-

Posts

4639 -

Joined

-

Last visited

-

Days Won

78

Content Type

Profiles

Forums

Gallery

Downloads

Blogs

Events

Posts posted by vasek00

-

-

3 часа назад, Валерий Вотяков сказал:

Спасибо! Диск надо вытаскивать и переразбивать?

Да вытаскивать и как можно поступить было выше, отрезать и формат в ext4 - minitool

-

1

1

-

-

1 час назад, Валерий Вотяков сказал:

Нет, я немного про другое: вот отключу я диск на котором Entware установлено и какие-то пакеты; что с роутером будет? не зависнет?

В моем случае нет, перестают работать те сервисы которые использую от Entware. Если сервисов нет, а просто какие либо утелитки то вообще не видно что что-то отключили.

-

1

1

-

-

3 часа назад, Валерий Вотяков сказал:

У меня подключен USB-диск на 1Tb и Usb-модем. На USB-диске уже есть информация и мне не хотелось бы её терять (Я ведь правильно понимаю что при подготовке накопителя для установки Entware он должен быть пустой?). Synchting я хочу поставить для синхронизации своих исходников между своим компьютером и USB-диском.

Synchting хочу поставить на внутреннюю память роутера только потому что не знаю, что случится если я отключу USB диск от роутера.

На Viva стоит Entware во внутренней памяти, затрачено 12,3 из 52, но это Viva

[I] Jan 1 00:00:08 kernel: Found 1st storage partition of size 33292288 bytes [I] Jan 1 00:00:08 kernel: Found 2nd storage partition of size 35651584 bytes [I] Jan 1 00:00:08 kernel: Registering UBI data partitions parser [W] Jan 1 00:00:08 kernel: Concatenating MTD devices: [W] Jan 1 00:00:08 kernel: (0): "Storage_A" [W] Jan 1 00:00:08 kernel: (1): "Storage_B"всего 33+35

Скрытый текст~ # opkg list-installed busybox - 1.36.1-1c dropbear - 2022.82-5 entware-release - 2024.02-1 findutils - 4.9.0-1a glib2 - 2.74.0-5 grep - 3.11-1 htop - 3.3.0-1 ip-bridge - 4.4.0-10b iptables - 1.4.21-4 jsonfilter - 2024-01-23-594cfa86-1 ldconfig - 2.27-11 libattr - 2.5.1-3 libblkid - 2.39.3-1 libc - 2.27-11 libffi - 3.4.2-2 libgcc - 8.4.0-11 libiconv-full - 1.17-1 libintl-full - 0.21.1-2 libjson-c - 0.17-1 libmbedtls - 2.28.7-2 libmount - 2.39.3-1 libncurses - 6.4-2a libncursesw - 6.4-2a libnl-tiny - 2023-12-05-965c4bf4-1 libpcre2 - 10.42-1 libpthread - 2.27-11 librt - 2.27-11 libslang2 - 2.3.3-2 libssh2 - 1.10.0-1 libssp - 8.4.0-11 libstdcpp - 8.4.0-11 libubox - 2024-01-26-c1be5057-1 libuuid - 2.39.3-1 locales - 2.27-9 mc - 4.8.30-1 opkg - 2022-02-24-d038e5b6-2 opt-ndmsv2 - 1.0-17 poorbox - 1.36.1-1 terminfo - 6.4-2a zlib - 1.3.1-1 zoneinfo-asia - 2024a-1 zoneinfo-core - 2024a-1 zoneinfo-europe - 2024a-1 ~ #~ # df Filesystem 1K-blocks Used Available Use% Mounted on /dev/root 25600 25600 0 100% / tmpfs 62296 0 62296 0% /dev tmpfs 62296 244 62052 0% /tmp /dev/ubi0_0 56540 13556 40064 25% /storage /dev/ubi0_0 56540 13556 40064 25% /opt ~ #после установки syncthing

~ # df Filesystem 1K-blocks Used Available Use% Mounted on /dev/root 25600 25600 0 100% / tmpfs 62296 0 62296 0% /dev tmpfs 62296 244 62052 0% /tmp /dev/ubi0_0 56540 31696 21924 59% /storage /dev/ubi0_0 56540 31696 21924 59% /opt ~ # -rwxr-xr-x 1 root root 25034752 Feb 13 16:29 syncthingВ KN1011 же всего

[I] Jan 1 00:00:08 kernel: Searching for suitable storage partitions... [I] Jan 1 00:00:08 kernel: Found 1st storage partition of size 16515072 bytes [I] Jan 1 00:00:08 kernel: Found 2nd storage partition of size 18874368 bytes [I] Jan 1 00:00:08 kernel: Registering UBI data partitions parser [W] Jan 1 00:00:08 kernel: Concatenating MTD devices: [W] Jan 1 00:00:08 kernel: (0): "Storage_A" [W] Jan 1 00:00:08 kernel: (1): "Storage_B"всего 16+18, даже если бы он влез то получаем

Скрытый текстCOMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME syncthing 6345 root cwd DIR 8,3 2048 147463 /opt/etc/init.d syncthing 6345 root rtd DIR 31,14 227 2036 / syncthing 6345 root txt REG 8,3 22347776 2490510 /opt/bin/syncthing syncthing 6345 root 0r CHR 1,3 0t0 250 /dev/null syncthing 6345 root 1w FIFO 0,8 0t0 812532 pipe syncthing 6345 root 2w FIFO 0,8 0t0 812531 pipe syncthing 6345 root 3uW REG 8,3 0 516106 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOCK syncthing 6345 root 4u a_inode 0,9 0 1025 [eventpoll:5,12,13,14,15,16,17,22,23] syncthing 6345 root 5r FIFO 0,8 0t0 813422 pipe syncthing 6345 root 6w FIFO 0,8 0t0 813422 pipe syncthing 6345 root 7w REG 8,3 1031 516107 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOG syncthing 6345 root 8w REG 8,3 231 516108 /opt/root/.local/state/syncthing/index-v0.14.0.db/MANIFEST-000000 syncthing 6345 root 9r REG 8,3 207 516110 /opt/root/.local/state/syncthing/index-v0.14.0.db/000004.ldb syncthing 6345 root 10w REG 8,3 399 516111 /opt/root/.local/state/syncthing/index-v0.14.0.db/000002.log syncthing 6345 root 11r DIR 8,3 2048 516112 /opt/root/Sync ... ~/.local/state/syncthing/index-v0.14.0.db # ls -l -rw-r--r-- 1 root root 3556 May 25 09:41 000002.log -rw-r--r-- 1 root root 207 May 25 09:36 000004.ldb -rw-r--r-- 1 root root 16 May 25 09:36 CURRENT -rw-r--r-- 1 root root 0 May 25 09:36 LOCK -rw-r--r-- 1 root root 1031 May 25 09:36 LOG -rw-r--r-- 1 root root 231 May 25 09:36 MANIFEST-000000 ~/.local/state/syncthing/index-v0.14.0.db #В любом случае на HDD/SDD

Второе по моему можно отрезать от диска если он до конца не заполнен, Minitool Partition Wizard.

только потому что не знаю, что случится если я отключу USB диск от роутера.

А что с ним должно случится, нажимаете кнопочку если она настроена на остановку или в WEB роутера. Или у вас что-то на него постоянно пишет?

-

2 часа назад, Валерий Вотяков сказал:

Мне бы не хотел устанавливать Synchting на диск

Повторюсь, что вы с его помощью хотите реализовать - синхронизацию 10-15Кбит в одном-двух файлах?

-

42 минуты назад, Валерий Вотяков сказал:

Никаких приложений не установлено. Может можно версию по-старее как-то накатить?

Данный сервис предназначен для синхронизации файлов между двумя устройствами, Тогда вопрос что вы собираетесь синхронизоровать беэ диска или как ?

-

4 часа назад, Михаил13 сказал:

На это не обращайте внимания, так и должно быть. Не чего у вас не весит.

-

6 часов назад, Михаил13 сказал:

[start] 2024/04/18 14:13:18 INFO: syncthing v1.27.3 "Gold Grasshopper" (go1.21.7 linux-mipsle) Entware@Entware 1970-01-01 00:00:00 UTC [noupgrade]

[start] 2024/04/18 14:13:19 WARNING: Error opening database: mkdir /.local: read-only file system (is another instance of Syncthing running?)

[monitor] 2024/04/18 14:13:19 INFO: Syncthing exited: exit status 1

[start] 2024/04/18 14:13:20 INFO: syncthing v1.27.3 "Gold Grasshopper" (go1.21.7 linux-mipsle) Entware@Entware 1970-01-01 00:00:00 UTC [noupgrade]

[start] 2024/04/18 14:13:20 WARNING: Error opening database: mkdir /.local: read-only file system (is another instance of Syncthing running?)

[monitor] 2024/04/18 14:13:20 INFO: Syncthing exited: exit status 1

[start] 2024/04/18 14:13:21 INFO: syncthing v1.27.3 "Gold Grasshopper" (go1.21.7 linux-mipsle) Entware@Entware 1970-01-01 00:00:00 UTC [noupgrade]

[start] 2024/04/18 14:13:22 WARNING: Error opening database: mkdir /.local: read-only file system (is another instance of Syncthing running?)

[monitor] 2024/04/18 14:13:22 INFO: Syncthing exited: exit status 1

[start] 2024/04/18 14:13:23 INFO: syncthing v1.27.3 "Gold Grasshopper" (go1.21.7 linux-mipsle) Entware@Entware 1970-01-01 00:00:00 UTC [noupgrade]

[start] 2024/04/18 14:13:23 WARNING: Error opening database: mkdir /.local: read-only file system (is another instance of Syncthing running?)

[monitor] 2024/04/18 14:13:23 INFO: Syncthing exited: exit status 1

[monitor] 2024/04/18 14:13:24 WARNING: 4 restarts in 6.22225282s; not retrying furtherread-only file system (is another instance of Syncthing running?) Хотя лог записался.

У вас два устройства - sda и sdb

/dev/sda2 on /tmp/mnt/01D9CD30AD2CF7F0 type tntfs /dev/sdb1 on /tmp/mnt/5bf97af8-024c-da4d-8f4b-9cd03b052e94 type ext4 /dev/sdb1 on /opt type ext4На вскидку вижу только

WARNING: Error opening database: mkdir /.local: read-only file system (is another instance of Syncthing running?)Это ошибка

https://forum.syncthing.net/t/solved-invalid-argument-is-another-instance-of-syncthing-running/12715

Ну это 2019 год, поискать по свежее.

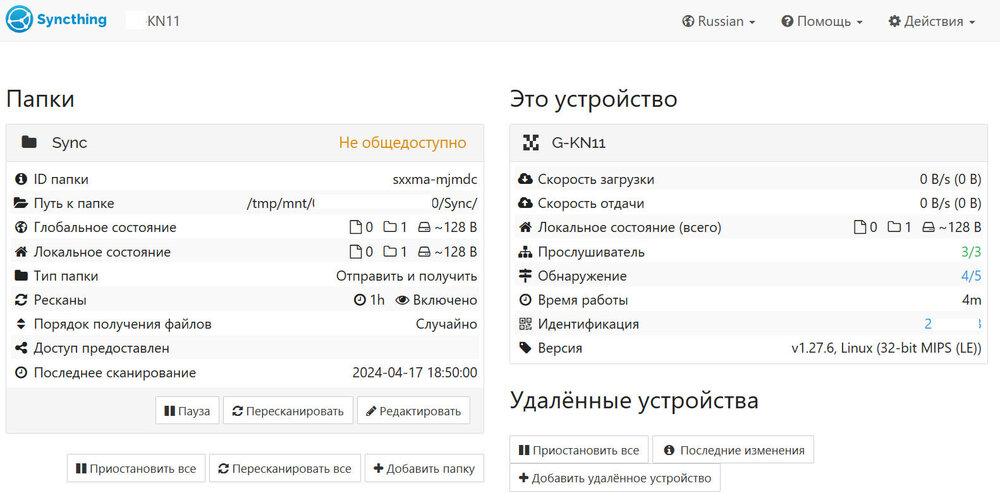

В реале же вот как выглядит (версия 1.27.6) на одном устройстве sda но с двумя разделами NTFS и Ext4. В настройках sync установлена папка которая указывает на NTFS раздел, но /opt/root/.local/state/syncthing это как раз на Ext4 разделе.

[start] 2024/04/17 15:13:21 INFO: Default folder created and/or linked to new config [start] 2024/04/17 15:13:21 INFO: Default config saved. Edit /opt/root/.local/state/syncthing/config.xml to taste (with Syncthing stopped) or use the GUI [start] 2024/04/17 15:13:21 INFO: Archiving a copy of old config file format at: /opt/root/.local/state/syncthing/config.xml.v0 ... [2QA22] 2024/04/17 15:13:23 INFO: Ready to synchronize "Default Folder" (default) (sendreceive) [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery.syncthing.net/v2/?noannounce&id=LYX....-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery-v4.syncthing.net/v2/?nolookup&id=LYX...-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery-v6.syncthing.net/v2/?nolookup&id=LYX...-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Completed initial scan of sendreceive folder "Default Folder" (default) [2QA22] 2024/04/17 15:13:23 INFO: Loading HTTPS certificate: open /opt/root/.local/state/syncthing/https-cert.pem: no such file or directory [2QA22] 2024/04/17 15:13:23 INFO: Creating new HTTPS certificate ... COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME syncthing 20372 root cwd DIR 8,2 3072 1101825 /opt/bin syncthing 20372 root rtd DIR 31,4 214 2085 / syncthing 20372 root txt REG 8,2 28096107 1101993 /opt/bin/syncthing syncthing 20372 root 0r CHR 1,3 0t0 1054 /dev/null syncthing 20372 root 1w FIFO 0,8 0t0 6488091 pipe syncthing 20372 root 2w FIFO 0,8 0t0 6488090 pipe syncthing 20372 root 3uW REG 8,2 0 1044493 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOCK syncthing 20372 root 4u a_inode 0,9 0 1028 [eventpoll:5,12,13,15,16,17,19,21,26,27,30,31,32,33,34] syncthing 20372 root 5r FIFO 0,8 0t0 6487583 pipe syncthing 20372 root 6w FIFO 0,8 0t0 6487583 pipe syncthing 20372 root 7w REG 8,2 19207 1044494 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOG syncthing 20372 root 8w REG 8,2 4057 1044505 /opt/root/.local/state/syncthing/index-v0.14.0.db/000073.log syncthing 20372 root 9w REG 8,2 215 1044506 /opt/root/.local/state/syncthing/index-v0.14.0.db/MANIFEST-000074 syncthing 20372 root 10r REG 8,2 1121 1044497 /opt/root/.local/state/syncthing/index-v0.14.0.db/000072.ldb syncthing 20372 root 11r REG 8,2 1181 1044502 /opt/root/.local/state/syncthing/index-v0.14.0.db/000071.ldb syncthing 20372 root 12u IPv6 6488116 0t0 TCP *:22000 (LISTEN) ... ~ # cd /opt/root/.local/state/syncthing ~/.local/state/syncthing # ls -l -rw-r--r-- 1 root root 794 Apr 17 18:13 cert.pem -rw------- 1 root root 8523 Apr 17 19:07 config.xml -rw------- 1 root root 8448 Apr 17 18:13 config.xml.v0 -rw-r--r-- 1 root root 782 Apr 17 18:13 https-cert.pem -rw------- 1 root root 288 Apr 17 18:13 https-key.pem drwxr-xr-x 2 root root 1024 Apr 18 21:05 index-v0.14.0.db -rw------- 1 root root 288 Apr 17 18:13 key.pem ~/.local/state/syncthing # -

1 час назад, Михаил13 сказал:

Удалил пакет syncthing. Установил пакет заново. Попробовал запустить с логом. Вот что вышло

read-only file system (is another instance of Syncthing running?) Хотя лог записался.

Лог роутера - момент монтирования и вывод "mount"

Скрытый текст~ # mount /dev/root on / type squashfs (ro,relatime) tmpfs on /dev type tmpfs (rw,nosuid,noexec,relatime) none on /dev/pts type devpts (rw,nosuid,noexec,relatime,mode=600,ptmxmode=000) proc on /proc type proc (rw,nosuid,nodev,noexec,relatime) tmpfs on /tmp type tmpfs (rw,nosuid,nodev,relatime) sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime) none on /sys/kernel/debug type debugfs (rw,nosuid,noexec,relatime) /dev/ubi0_0 on /storage type ubifs (rw,relatime,compr=zlib) /dev/sda1 on /tmp/mnt/01DA.....0 type tntfs (rw,nosuid,noexec,noatime,uid=0,gid=1000,umask=02,allow_utime=0020,utf8,min_prealloc_size=64k,max_prealloc_size=970981368,readahead=4M,user_xattr,case_insensitive,disable_sparse,fail_safe,hidden=show,dotfile=show,protected_system=ignore,errors=continue,mft_zone_multiplier=1) /dev/sda2 on /tmp/mnt/98ef....a01 type ext4 (rw,noatime,data=ordered) /dev/sda2 on /opt type ext4 (rw,noatime,data=ordered) ~ #И так же покажите свой (тут их два, текущий v1.27.6)

Скрытый текст~ # ls -l /opt/bin | grep syncthing -rwxr-xr-x 1 root root 28096107 Apr 9 09:22 syncthing -rwxr-xr-x 1 root root 25034752 Feb 13 16:29 syncthing-1.27.3-1 ~ # -

42 минуты назад, Михаил13 сказал:

Отсюда поподробнее?

Для начала запустить с логом, как пример был выше. Возможно у вас проблема с доступом к

[2QA22] 2024/04/17 15:41:53 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) starting -

2 часа назад, Михаил13 сказал:

В репозитарии версия 1.27.3. На сайте syncthing есть уже 1.27.6. Будет ли у нас работать?

А кто мешает проверить. Идем на https://github.com/syncthing/syncthing/releases берем для mipsle (KN1011)

скачиваем, распаковываем нам нужен один файл :

/opt/bin # mv syncthing syncthing-1.27.3-1переписываем нужный нам файл в данный каталог и даем ему потом права

/opt/bin # ls -l ... -rw-r--r-- 1 root root 28096107 Apr 9 09:22 syncthing -rwxr-xr-x 1 root root 25034752 Feb 13 16:29 syncthing-1.27.3-1 ... /opt/bin # chmod 755 syncthing /opt/bin #Далее запустим с логом и ниже со сменой IP:port

Скрытый текст/opt/bin # ./syncthing --logfile=/opt/var/syncthing_log [monitor] 2024/04/17 15:13:20 INFO: Log output saved to file "/opt/var/syncthing_log" [start] 2024/04/17 15:13:20 INFO: syncthing v1.27.6 "Gold Grasshopper" (go1.22.2 linux-mipsle) builder@github.syncthing.net 2024-04-08 09:14:27 UTC [start] 2024/04/17 15:13:20 INFO: Generating ECDSA key and certificate for syncthing... [start] 2024/04/17 15:13:21 INFO: Default folder created and/or linked to new config [start] 2024/04/17 15:13:21 INFO: Default config saved. Edit /opt/root/.local/state/syncthing/config.xml to taste (with Syncthing stopped) or use the GUI [start] 2024/04/17 15:13:21 INFO: Archiving a copy of old config file format at: /opt/root/.local/state/syncthing/config.xml.v0 [2QA22] 2024/04/17 15:13:21 INFO: My ID: 2QA22BB-.....-EVCQIQ3 [2QA22] 2024/04/17 15:13:22 INFO: Single thread SHA256 performance is 6.8 MB/s using crypto/sha256 (6.7 MB/s using minio/sha256-simd). [2QA22] 2024/04/17 15:13:23 INFO: Hashing performance is 6.15 MB/s [2QA22] 2024/04/17 15:13:23 INFO: Running database migration 20... [2QA22] 2024/04/17 15:13:23 INFO: Compacting database after migration... [2QA22] 2024/04/17 15:13:23 INFO: Detected upgrade from v1.27.3 to v1.27.6 [2QA22] 2024/04/17 15:13:23 INFO: Overall send rate is unlimited, receive rate is unlimited [2QA22] 2024/04/17 15:13:23 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) starting [2QA22] 2024/04/17 15:13:23 INFO: Ready to synchronize "Default Folder" (default) (sendreceive) [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery.syncthing.net/v2/?noannounce&id=LYX....-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery-v4.syncthing.net/v2/?nolookup&id=LYX...-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: global discovery server https://discovery-v6.syncthing.net/v2/?nolookup&id=LYX...-NA2MIAW [2QA22] 2024/04/17 15:13:23 INFO: Completed initial scan of sendreceive folder "Default Folder" (default) [2QA22] 2024/04/17 15:13:23 INFO: Loading HTTPS certificate: open /opt/root/.local/state/syncthing/https-cert.pem: no such file or directory [2QA22] 2024/04/17 15:13:23 INFO: Creating new HTTPS certificate [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: IPv4 local broadcast discovery on port 21027 [2QA22] 2024/04/17 15:13:23 INFO: Using discovery mechanism: IPv6 local multicast discovery on address [ff12::8384]:21027 [2QA22] 2024/04/17 15:13:23 INFO: QUIC listener ([::]:22000) starting [2QA22] 2024/04/17 15:13:23 INFO: TCP listener ([::]:22000) starting [2QA22] 2024/04/17 15:13:24 INFO: GUI and API listening on 127.0.0.1:8384 [2QA22] 2024/04/17 15:13:24 INFO: Access the GUI via the following URL: http://127.0.0.1:8384/ [2QA22] 2024/04/17 15:13:24 INFO: My name is "KN11" [2QA22] 2024/04/17 15:13:24 WARNING: Syncthing should not run as a privileged or system user. Please consider using a normal user account. ^C Выход нажать Ctrl-C [monitor] 2024/04/17 15:13:29 INFO: Signal 2 received; exiting [2QA22] 2024/04/17 15:13:29 INFO: QUIC listener ([::]:22000) shutting down [2QA22] 2024/04/17 15:13:29 INFO: Detected 1 NAT service [2QA22] 2024/04/17 15:13:29 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) shutting down [2QA22] 2024/04/17 15:13:29 INFO: TCP listener ([::]:22000) shutting down [2QA22] 2024/04/17 15:13:29 INFO: Exiting /opt/bin #В итоге запускаем

/opt/bin # ./syncthing -gui-address=0.0.0.0:8384 [start] 2024/04/17 15:41:50 INFO: syncthing v1.27.6 "Gold Grasshopper" (go1.22.2 linux-mipsle) builder@github.syncthing.net 2024-04-08 09:14:27 UTC [2QA22] 2024/04/17 15:41:51 INFO: My ID: 2QA22BB-MM4SCTN-UQCQK6I-JPV3BR7-BIC3AAZ-TGQ73LO-OTWAVRR-EVCQIQ3 [2QA22] 2024/04/17 15:41:52 INFO: Single thread SHA256 performance is 6.8 MB/s using crypto/sha256 (6.7 MB/s using minio/sha256-simd). [2QA22] 2024/04/17 15:41:53 INFO: Hashing performance is 5.95 MB/s [2QA22] 2024/04/17 15:41:53 INFO: Overall send rate is unlimited, receive rate is unlimited ..... [2QA22] 2024/04/17 15:41:53 INFO: Using discovery mechanism: IPv4 local broadcast discovery on port 21027 [2QA22] 2024/04/17 15:41:53 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) starting [2QA22] 2024/04/17 15:41:53 INFO: Using discovery mechanism: IPv6 local multicast discovery on address [ff12::8384]:21027 [2QA22] 2024/04/17 15:41:53 INFO: Ready to synchronize "Default Folder" (default) (sendreceive) [2QA22] 2024/04/17 15:41:53 INFO: Completed initial scan of sendreceive folder "Default Folder" (default) [2QA22] 2024/04/17 15:41:53 INFO: QUIC listener ([::]:22000) starting [2QA22] 2024/04/17 15:41:53 INFO: TCP listener ([::]:22000) starting [2QA22] 2024/04/17 15:41:53 INFO: GUI and API listening on [::]:8384 [2QA22] 2024/04/17 15:41:53 INFO: Access the GUI via the following URL: http://127.0.0.1:8384/ ...доступ с ПК получил

-

Ведь написал что можно удалить весь каталог /opt/etc/syncthing и потом просто запустить.

Скрипт запуска стандартный как и у многих приложений

#!/bin/sh if [ ! -d "/opt/etc/syncthing" ]; then syncthing -generate="/opt/etc/syncthing" sed -i 's|127\.0\.0\.1|0.0.0.0|' /opt/etc/syncthing/config.xml elif [ -n "$(grep '127\.0\.0\.1' /opt/etc/syncthing/config.xml)" ]; then sed -i 's|127\.0\.0\.1|0.0.0.0|' /opt/etc/syncthing/config.xml fi ENABLED=yes PROCS=syncthing ARGS="" PREARGS="" DESC=$PROCS PATH=/opt/sbin:/opt/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin . /opt/etc/init.d/rc.funcВажная в нем строка ". /opt/etc/init.d/rc.func" так как в ней есть как раз и start | stop | restart

Можете удалить через - "opkg remove <имя пакета>" - команда удалит установленный ранее пакет, но думаю у вас он так же не запустится после переустановки. Нужно смотреть что у вас и как - на что устанавливаете, какой раздел и какой размер и так далее.

-

6 часов назад, Михаил13 сказал:

Еще вопрос я уже раз 20 устанавливал OPKG и менял флэшки. При установке syncthing нигде на роутере не может оставлять конфиг и его потом подтягивать?

Берем исходник http://bin.entware.net/mipselsf-k3.4/syncthing_1.27.3-1_mipsel-3.4.ipk

Распаковываем его на ПК и видим, что кроме двух файлов там не чего нет кроме самого syncthing и скрипта запуска -> конф создается при первом запуске. Что делаю

Скрытый текст/opt/etc/syncthing # mv config.xml config.xml.orig /opt/etc/init.d # ./K92syncthing start grep: /opt/etc/syncthing/config.xml: No such file or directory Starting syncthing... done. /opt/etc/init.d # /opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 127.0.0.1:8384 0.0.0.0:* LISTEN 30115/syncthing *************************** tcp 0 0 :::22000 :::* LISTEN 30115/syncthing udp 0 0 0.0.0.0:21027 0.0.0.0:* 30115/syncthing udp 0 0 0.0.0.0:50367 0.0.0.0:* 30115/syncthing udp 0 0 :::21027 :::* 30115/syncthing udp 0 0 :::54663 :::* 30115/syncthing udp 0 0 :::22000 :::* 30115/syncthing /opt/etc/init.d #Как видим в данном случае получили 127.0.0.1:8384 и это не правильно, делаю правку в конф файле на

<gui enabled="true" tls="false" debugging="false" sendBasicAuthPrompt="false"> <address>0.0.0.0:8384</address> <apikey>zz6L........JSc</apikey> <theme>default</theme> </gui>

Делаю рестарт

/opt/etc/init.d # ./K92syncthing restart Shutting down syncthing... done. Starting syncthing... done. /opt/etc/init.d # /opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 :::22000 :::* LISTEN 30535/syncthing tcp 0 0 :::8384 :::* LISTEN 30535/syncthing *********************** udp 0 0 0.0.0.0:21027 0.0.0.0:* 30535/syncthing udp 0 0 0.0.0.0:59081 0.0.0.0:* 30535/syncthing udp 0 0 :::21027 :::* 30535/syncthing udp 0 0 :::60809 :::* 30535/syncthing udp 0 0 :::22000 :::* 30535/syncthing /opt/etc/init.d #После проделанной работы без проблем попал на WEB GUI - 192.168.1.98:8384 на первоначальные настройки.

Повторил - удалил весь каталог /opt/etc/syncthing и запустил так сказать с чистого листа

Скрытый текст/opt/etc/init.d # ./K92syncthing start 2024/04/16 21:21:45 INFO: Generating ECDSA key and certificate for syncthing... 2024/04/16 21:21:45 INFO: Device ID: GBOHTHD-............-WGJ3CA3 2024/04/16 21:21:45 INFO: Default folder created and/or linked to new config Starting syncthing... done. /opt/etc/init.d # /opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 :::22000 :::* LISTEN 31351/syncthing tcp 0 0 :::8384 :::* LISTEN 31351/syncthing ***************** udp 0 0 0.0.0.0:21027 0.0.0.0:* 31351/syncthing udp 0 0 0.0.0.0:57956 0.0.0.0:* 31351/syncthing udp 0 0 :::21027 :::* 31351/syncthing udp 0 0 :::52329 :::* 31351/syncthing udp 0 0 :::22000 :::* 31351/syncthing /opt/etc/init.d # в созданном конф файле <gui enabled="true" tls="false" debugging="false" sendBasicAuthPrompt="false"> <address>0.0.0.0:8384</address> <apikey>TuJ............dW3</apikey> <theme>default</theme> </gui>

Проблем опять же нет, HDD (Ext4) на котором есть место проблем не возникло, далее в настройках сменил на 192.168.1.98 и указал место /tmp/mnt/.......NTFS-раздел-HDD-диска.

-

1 час назад, Михаил13 сказал:

Syncthing на роутере запускался точно.

Клиент ПК 192.168.1.2, роутер 192.168.1.98

Скрытый текст~ # cd /opt/etc/init.d /opt/etc/init.d # ls -l ... -rwxr-xr-x 1 root root 474 Feb 13 16:29 K92syncthing ... /opt/etc/init.d # ./K92syncthing start Starting syncthing... done. /opt/etc/init.d # ps | grep sync 32183 root 609m S syncthing 32195 root 609m SN /opt/bin/syncthing /opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 192.168.1.98:8384 0.0.0.0:* LISTEN 32195/syncthing tcp 0 0 :::22000 :::* LISTEN 32195/syncthing udp 0 0 0.0.0.0:21027 0.0.0.0:* 32195/syncthing udp 0 0 0.0.0.0:56502 0.0.0.0:* 32195/syncthing udp 0 0 :::21027 :::* 32195/syncthing udp 0 0 :::49128 :::* 32195/syncthing udp 0 0 :::22000 :::* 32195/syncthing /opt/etc/init.d # lsof -p 32195 COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME syncthing 32195 root cwd DIR 8,2 1024 999431 /opt/etc/init.d syncthing 32195 root rtd DIR 31,4 214 2085 / syncthing 32195 root txt REG 8,2 25034752 1101992 /opt/bin/syncthing syncthing 32195 root 0r CHR 1,3 0t0 1054 /dev/null syncthing 32195 root 1w FIFO 0,8 0t0 2693560 pipe syncthing 32195 root 2w FIFO 0,8 0t0 2693559 pipe syncthing 32195 root 3uW REG 8,2 0 1044493 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOCK syncthing 32195 root 4u a_inode 0,9 0 1028 [eventpoll:5,12,13,14,15,16,17,18,19,20,21,22,23,24,25] syncthing 32195 root 5r FIFO 0,8 0t0 2683837 pipe syncthing 32195 root 6w FIFO 0,8 0t0 2683837 pipe syncthing 32195 root 7w REG 8,2 5708 1044494 /opt/root/.local/state/syncthing/index-v0.14.0.db/LOG syncthing 32195 root 8w REG 8,2 747 1044497 /opt/root/.local/state/syncthing/index-v0.14.0.db/000021.log syncthing 32195 root 9w REG 8,2 220 1044498 /opt/root/.local/state/syncthing/index-v0.14.0.db/MANIFEST-000022 syncthing 32195 root 10r REG 8,2 4056 1044495 /opt/root/.local/state/syncthing/index-v0.14.0.db/000020.ldb syncthing 32195 root 11r REG 8,2 501 1044496 /opt/root/.local/state/syncthing/index-v0.14.0.db/000019.ldb syncthing 32195 root 12u IPv6 2693562 0t0 TCP *:22000 (LISTEN) syncthing 32195 root 13u IPv6 2690399 0t0 UDP *:22000 syncthing 32195 root 14u IPv4 2683865 0t0 TCP 192.168.1.98:8384 (LISTEN) syncthing 32195 root 15u IPv4 2694477 0t0 TCP 192.168.1.98:57276->207.ххх.ххх.ххх:1723 (ESTABLISHED) syncthing 32195 root 16u IPv4 2692052 0t0 TCP 192.168.1.98:8384->192.168.1.2:50739 (ESTABLISHED) syncthing 32195 root 17u IPv4 2692055 0t0 TCP 192.168.1.98:8384->192.168.1.2:50740 (ESTABLISHED) syncthing 32195 root 18u IPv4 2693564 0t0 UDP *:56502 syncthing 32195 root 19u IPv4 2692056 0t0 TCP 192.168.1.98:8384->192.168.1.2:50741 (ESTABLISHED) syncthing 32195 root 20u IPv6 2693565 0t0 UDP *:49128 syncthing 32195 root 21u IPv4 2692057 0t0 TCP 192.168.1.98:8384->192.168.1.2:50742 (ESTABLISHED) syncthing 32195 root 22u IPv4 2693566 0t0 UDP *:21027 syncthing 32195 root 23u IPv6 2693567 0t0 UDP *:21027 syncthing 32195 root 24u IPv4 2694460 0t0 TCP 192.168.1.98:8384->192.168.1.2:50743 (ESTABLISHED) syncthing 32195 root 25u IPv4 2694024 0t0 TCP 192.168.1.98:8384->192.168.1.2:50744 (ESTABLISHED) syncthing 32195 root 26r a_inode 0,9 0 1028 inotify syncthing 32195 root 27u a_inode 0,9 0 1028 [eventpoll:26,28] syncthing 32195 root 28r FIFO 0,8 0t0 2690402 pipe syncthing 32195 root 29w FIFO 0,8 0t0 2690402 pipe /opt/etc/init.d #по конф

<gui enabled="true" tls="false" debugging="false" sendBasicAuthPrompt="false"> <address>192.168.1.98:8384</address> <user>admin</user> <password>$2a$10$0lU.....Z0o5SxoyG</password> <apikey>Wm9HP9KD.....zxog</apikey> <theme>default</theme> </gui>

-

6 часов назад, Михаил13 сказал:

Сейчас после установки OPKG на флэшку и последующего установки sync не могу зайти в интерфейс sync роутера. Пробовал и как раньше установить syncthing и запускать не через скрипт, и через скрипт, и менял в конфиге адрес с 127.0.0.1:8384 на 0.0.0.0:8384. Никак не могу через браузер ноутбука попасть в клиент роутера.

Что я делаю не так? Помогите люди добрые!

Установил на HDD, потом на ПК набрал - IP_роутера:8384 и попал на страницу настройки. После настроек (ну не люблю 0.0.0.0, 192.168.1.98 адрес роутера) получил

<gui enabled="true" tls="false" debugging="false" sendBasicAuthPrompt="false"> <address>192.168.1.98:8384</address> <user>admin</user> <password>$2a$10$0l.....o5SxoyG</password> <apikey>Wm9HP......DXY5SmvYjzxog</apikey> <theme>default</theme> </gui> opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 192.168.1.98:8384 0.0.0.0:* LISTEN 16504/syncthing tcp 0 0 :::22000 :::* LISTEN 16504/syncthing udp 0 0 0.0.0.0:21027 0.0.0.0:* 16504/syncthing udp 0 0 0.0.0.0:58992 0.0.0.0:* 16504/syncthing udp 0 0 :::21027 :::* 16504/syncthing udp 0 0 :::55378 :::* 16504/syncthing udp 0 0 :::22000 :::* 16504/syncthing /opt/etc/init.d #

Еще может быть причина, что он у вас просто не запустился

/opt/etc/init.d # ps | grep sync 16493 root 608m S syncthing 16504 root 609m SN /opt/bin/syncthing /opt/etc/init.d # -

37 минут назад, kaskadtelekom сказал:

Добрый день, коллеги! Не очень силен в данном вопросе, но меня посетила такая мысль, на сколько сложным для Интернет-центра будет задача конвертировать rtsp поток, например с IP камеры и транслировать его в локальную сеть по DLNA, так, чтобы можно было без лишних заморочек и устройств отображать картинку с камер наблюдения или видеорегистратора, который установлен далеко от телевизора? Учитывая распространенность систем видеонаблюдения, думаю очень перспективная и удобная функция. Хочется получить всё в стандартной прошивке, без бубна и прочих телодвижений.

На счет распространенность а кто мешает получить с нее поток просто по http или камера не может (слабоват ее функционал) или vlc.

Возможно вам поможет mediatomb с его возможностями или

но в обоих вариантах это Entware плюс доп.сервис.

-

2 часа назад, Doverenny0 сказал:

Спасибо. Всё-таки не успешно. В консоли пишет, что запустилось (done), но веб-интерфейс не открывается.

И на других устройствах syncthing показывает, что Keenetic не подключен.Проверил, да вы правы, даже скаченная с https://github.com/syncthing/syncthing/releases не исправила проблему.

При сравнение двух 1.19 и 1.20 ошибок в загрузке нет

Скрытый текст1.19

удаляем если есть папка /opt/etc/syncthing

/opt/bin # ./syncthing.119 -generate="/opt/etc/syncthing" 17:28:28 INFO: Generating ECDSA key and certificate for syncthing... 2022/06/16 17:28:28 Device ID: FDX.......GPQT 17:28:28 INFO: Default folder created and/or linked to new config /opt/bin # sed -i 's|127.0.0.1:8384|0.0.0.0:8384|' /opt/etc/syncthing/config.xml /opt/bin # ./syncthing.119 [start] 17:29:02 INFO: syncthing v1.19.1 "Fermium Flea" (go1.18 linux-mipsle) me@builder 2022-04-13 08:47:51 UTC [noupgrade] [FDXQX] 17:29:02 INFO: My ID: FDX....GPQT [FDXQX] 17:29:03 INFO: Single thread SHA256 performance is 6.0 MB/s using crypto/sha256 (5.9 MB/s using minio/sha256-simd). [FDXQX] 17:29:05 INFO: Hashing performance is 5.56 MB/s [FDXQX] 17:29:05 INFO: Running database migration 1... [FDXQX] 17:29:05 INFO: Running database migration 2... [FDXQX] 17:29:05 INFO: Running database migration 3... [FDXQX] 17:29:05 INFO: Running database migration 5... [FDXQX] 17:29:05 INFO: Running database migration 6... [FDXQX] 17:29:05 INFO: Running database migration 7... [FDXQX] 17:29:05 INFO: Running database migration 9... [FDXQX] 17:29:05 INFO: Running database migration 10... [FDXQX] 17:29:05 INFO: Running database migration 11... [FDXQX] 17:29:05 INFO: Running database migration 13... [FDXQX] 17:29:05 INFO: Running database migration 14... [FDXQX] 17:29:05 INFO: Running database migration 16... [FDXQX] 17:29:05 INFO: Running database migration 17... [FDXQX] 17:29:05 INFO: Running database migration 19... [FDXQX] 17:29:05 INFO: Compacting database after migration... [FDXQX] 17:29:05 INFO: Overall send rate is unlimited, receive rate is unlimited [FDXQX] 17:29:05 INFO: No stored folder metadata for "default"; recalculating [FDXQX] 17:29:05 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) starting [FDXQX] 17:29:05 INFO: Using discovery mechanism: global discovery server https://discovery.syncthing.net/v2/?noannounce&id=LYX.......MIAW [FDXQX] 17:29:05 INFO: Using discovery mechanism: global discovery server https://discovery-v4.syncthing.net/v2/?nolookup&id=LYX......MIAW [FDXQX] 17:29:05 INFO: Using discovery mechanism: global discovery server https://discovery-v6.syncthing.net/v2/?nolookup&id=LYX......MIAW [FDXQX] 17:29:05 INFO: Using discovery mechanism: IPv4 local broadcast discovery on port 21027 [FDXQX] 17:29:05 INFO: Loading HTTPS certificate: open /opt/etc/syncthing/https-cert.pem: no such file or directory [FDXQX] 17:29:05 INFO: Creating new HTTPS certificate [FDXQX] 17:29:05 INFO: TCP listener ([::]:22000) starting [FDXQX] 17:29:05 INFO: Using discovery mechanism: IPv6 local multicast discovery on address [ff12::8384]:21027 [FDXQX] 17:29:05 INFO: QUIC listener ([::]:22000) starting [FDXQX] 17:29:05 INFO: Ready to synchronize "Default Folder" (default) (sendreceive) [FDXQX] 17:29:05 INFO: Completed initial scan of sendreceive folder "Default Folder" (default) [FDXQX] 17:29:05 INFO: GUI and API listening on [::]:8384 [FDXQX] 17:29:05 INFO: Access the GUI via the following URL: http://127.0.0.1:8384/ [FDXQX] 17:29:05 INFO: My name is "KN18" [FDXQX] 17:29:05 WARNING: Syncthing should not run as a privileged or system user. Please consider using a normal user account. [FDXQX] 17:29:15 INFO: New NAT port mapping: external TCP address 2хх.ххх.ххх.хх3:12679 to local address [::]:22000. [FDXQX] 17:29:15 INFO: New NAT port mapping: external TCP address 2хх.ххх.ххх.хх3:62304 to local address [::]:22000. [FDXQX] 17:29:15 INFO: Detected 2 NAT services [FDXQX] 17:29:24 INFO: quic://0.0.0.0:22000 detected NAT type: Port restricted NAT [FDXQX] 17:29:24 INFO: quic://0.0.0.0:22000 resolved external address quic://2хх.ххх.ххх.хх 3:35893 (via stun.syncthing.net:3478) [FDXQX] 17:30:26 INFO: Joined relay relay://1хх.ххх.ххх.хх6:22067 ~ # netstat -ntulp | grep sync tcp 0 0 :::22000 :::* LISTEN 6024/syncthing.119 tcp 0 0 :::8384 :::* LISTEN 6024/syncthing.119 udp 0 0 0.0.0.0:49591 0.0.0.0:* 6024/syncthing.119 udp 0 0 0.0.0.0:21027 0.0.0.0:* 6024/syncthing.119 udp 0 0 :::56994 :::* 6024/syncthing.119 udp 0 0 :::22000 :::* 6024/syncthing.119 udp 0 0 :::21027 :::* 6024/syncthing.119 ~ #Браузер защел на 192.168.130.97:8384

1.20

удаляем если есть папка /opt/etc/syncthing

/opt/bin # ./syncthing -generate="/opt/etc/syncthing" 2022/06/16 14:38:37 INFO: Generating ECDSA key and certificate for syncthing... 2022/06/16 14:38:38 Device ID: 3YC....JQI 2022/06/16 14:38:38 INFO: Default folder created and/or linked to new config /opt/bin # sed -i 's|127.0.0.1:8384|0.0.0.0:8384|' /opt/etc/syncthing/config.xml /opt/bin # ./syncthing [start] 2022/06/16 14:38:55 INFO: syncthing v1.20.2 "Fermium Flea" (go1.18.3 linux-mipsle) teamcity@build.syncthing.net 2022-05-31 20:19:44 UTC [3JUQK] 2022/06/16 14:38:56 INFO: My ID: 3JU...XQS [3JUQK] 2022/06/16 14:38:57 INFO: Single thread SHA256 performance is 6.0 MB/s using minio/sha256-simd (6.0 MB/s using crypto/sha256). [3JUQK] 2022/06/16 14:38:58 INFO: Hashing performance is 5.55 MB/s [3JUQK] 2022/06/16 14:38:58 INFO: Overall send rate is unlimited, receive rate is unlimited [3JUQK] 2022/06/16 14:38:58 INFO: Ready to synchronize "Default Folder" (default) (sendreceive) [3JUQK] 2022/06/16 14:38:58 INFO: Using discovery mechanism: global discovery server https://discovery.syncthing.net/v2/?noannounce&id=LYX...2MIAW [3JUQK] 2022/06/16 14:38:58 INFO: Using discovery mechanism: global discovery server https://discovery-v4.syncthing.net/v2/?nolookup&id=LYX...2MIAW [3JUQK] 2022/06/16 14:38:58 INFO: Using discovery mechanism: global discovery server https://discovery-v6.syncthing.net/v2/?nolookup&id=LYX...2MIAW [3JUQK] 2022/06/16 14:38:58 INFO: Relay listener (dynamic+https://relays.syncthing.net/endpoint) starting [3JUQK] 2022/06/16 14:38:58 INFO: Using discovery mechanism: IPv4 local broadcast discovery on port 21027 [3JUQK] 2022/06/16 14:38:58 INFO: Using discovery mechanism: IPv6 local multicast discovery on address [ff12::8384]:21027 [3JUQK] 2022/06/16 14:38:58 INFO: Failed initial scan of sendreceive folder "Default Folder" (default) [3JUQK] 2022/06/16 14:38:58 WARNING: Error on folder "Default Folder" (default): folder path missing [3JUQK] 2022/06/16 14:38:58 INFO: TCP listener ([::]:22000) starting [3JUQK] 2022/06/16 14:38:58 INFO: QUIC listener ([::]:22000) starting [3JUQK] 2022/06/16 14:38:58 INFO: GUI and API listening on 127.0.0.1:8384 [3JUQK] 2022/06/16 14:38:58 INFO: Access the GUI via the following URL: http://127.0.0.1:8384/ [3JUQK] 2022/06/16 14:38:58 INFO: My name is "KN18" [3JUQK] 2022/06/16 14:38:58 WARNING: Syncthing should not run as a privileged or system user. Please consider using a normal user account. [3JUQK] 2022/06/16 14:39:08 INFO: New NAT port mapping: external TCP address 2xx.xxx.xxx.xx3:51484 to local address [::]:22000. [3JUQK] 2022/06/16 14:39:08 INFO: New NAT port mapping: external TCP address 2xx.xxx.xxx.xx3:3143 to local address [::]:22000. [3JUQK] 2022/06/16 14:39:08 INFO: Detected 2 NAT services [3JUQK] 2022/06/16 14:40:17 INFO: Joined relay relay://2xx.xx.xx.x0:27040 ~ # netstat -ntulp | grep sync tcp 0 0 127.0.0.1:8384 0.0.0.0:* LISTEN 6171/syncthing tcp 0 0 :::22000 :::* LISTEN 6171/syncthing udp 0 0 0.0.0.0:60025 0.0.0.0:* 6171/syncthing udp 0 0 0.0.0.0:21027 0.0.0.0:* 6171/syncthing udp 0 0 :::22000 :::* 6171/syncthing udp 0 0 :::60666 :::* 6171/syncthing udp 0 0 :::21027 :::* 6171/syncthing ~ #И даже на 1.20 rc3 то же самое

/opt/bin # ./syncthing [start] 2022/06/16 14:52:52 INFO: syncthing v1.20.3-rc.1 "Fermium Flea" (go1.18.3 linux-mipsle) teamcity@build.syncthing.net 2022-06-13 04:02:19 UTC [start] 2022/06/16 14:52:52 INFO: Automatic upgrade is always enabled for candidate releases. ... [3JUQK] 2022/06/16 14:49:39 INFO: Detected upgrade from v1.20.2 to v1.20.3-rc.1 ...1.19 встает без проблем

-

20 минут назад, Doverenny0 сказал:

Большое спасибо! Успешно обновился.

А вы не сталкивались с подобной проблемой синхронизации на разных устройствах? А именно: при переименовывании в имени файла с больших букв на маленькие и обратно, удаляются файлы.

Как описал в примере:

1) Файл Kal-me.md переименовал в Kal-mE;

2) затем, переименовал обратно в Kal-me.md - файл удалился на всех устройствах.Это было уже давно, можно попробовать как нибудь.

-

6 часов назад, Doverenny0 сказал:

Понял. А не подскажете: как вы обновляли Syncthing? Выше пишут про репозиторий, но у меня в Entware только версия 1.19.1.

Так и есть

~ # opkg list | grep syncthing syncthing - 1.19.1-1 - Syncthing replaces proprietary sync and cloud services with something open, trustworthy and decentralized. Your data is your data alone and you deserve to choose where it is stored, if it is shared with some third party and how it's transmitted over the Internet. ~ #На клиенте использовал SyncTrayzor там же есть и для

Linux 64-bit (x86-64) ⋅ 32-bit (x86-32) ⋅ ARM ⋅ ARM64 ⋅ MIPS ⋅ MIPS64 ⋅ MIPS-LE ⋅ MIPS64-LE ⋅ PPC64 ⋅ PPC64-LE ⋅ RISC-V ⋅ S/390xhttps://syncthing.net/downloads/

Скачиваете для MIPS-LE там вам из архива нужен только один файл и это "syncthing", переписываете его на /opt/bin/syncthing и конечно же "chmod 755 syncthing" в итоге получаете версию v1.20.2

-

10 минут назад, Doverenny0 сказал:

Не загружается скришот :с

В виду наличия всего 5МБ для размещения файлов то приходиться удалять старые для того чтоб разместить новые.

-

dns-proxy rebind-protect auto https upstream https://dns.google/dns-query dnsm on ISP https upstream https://cloudflare-dns.com/dns-query dnsm on ISP dns_server = 127.0.0.1:40508 . # https://dns.google/dns-query@dnsm dns_server = 127.0.0.1:40509 . # https://cloudflare-dns.com/dns-query@dnsm DNS Servers Ip Port R.Sent A.Rcvd NX.Rcvd Med.Resp Avg.Resp Rank 127.0.0.1 40508 5 2 3 135ms 125ms 3 127.0.0.1 40509 151 148 3 32ms 39ms 10 [W] Feb 18 00:47:18 https-dns-proxy: 2C2E: curl request failed with 0: No error [W] Feb 18 00:47:18 https-dns-proxy: 2C2E: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1146 ms: Operation timed out [W] Feb 18 00:47:18 https-dns-proxy: 8218: curl request failed with 0: No error [W] Feb 18 00:47:18 https-dns-proxy: 8218: curl error message: Failed to connect to dns.google port 443 after 1219 ms: Operation timed out [W] Feb 18 00:47:18 https-dns-proxy: 4E44: curl request failed with 0: No error [W] Feb 18 00:47:18 https-dns-proxy: 4E44: curl error message: Failed to connect to dns.google port 443 after 1025 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: 66A6: curl request failed with 0: No error [W] Feb 18 00:47:19 https-dns-proxy: 66A6: curl error message: Failed to connect to dns.google port 443 after 563 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: 487B: curl request failed with 0: No error [W] Feb 18 00:47:19 https-dns-proxy: 487B: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1252 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: 3621: curl request failed with 0: No error [W] Feb 18 00:47:19 https-dns-proxy: 3621: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1266 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: DE0E: curl request failed with 0: No error [W] Feb 18 00:47:19 https-dns-proxy: DE0E: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1142 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: 2E0A: curl request failed with 0: No error [W] Feb 18 00:47:19 https-dns-proxy: 2E0A: curl error message: Failed to connect to dns.google port 443 after 1839 ms: Operation timed out [W] Feb 18 00:47:19 https-dns-proxy: 1D10: curl request failed with 0: No error ю... [W] Feb 18 00:47:26 https-dns-proxy: DC61: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1325 ms: Operation timed out [W] Feb 18 00:47:26 https-dns-proxy: A822: curl request failed with 0: No error [W] Feb 18 00:47:26 https-dns-proxy: A822: curl error message: Failed to connect to dns.google port 443 after 1435 ms: Operation timed out [W] Feb 18 00:47:26 https-dns-proxy: 416F: curl request failed with 0: No error [W] Feb 18 00:47:26 https-dns-proxy: 416F: curl error message: Failed to resolve host 'dns.google' with timeout after 1000 ms [W] Feb 18 00:47:26 https-dns-proxy: AAE2: curl request failed with 0: No error [W] Feb 18 00:47:26 https-dns-proxy: AAE2: curl error message: Failed to resolve host 'dns.google' with timeout after 1000 ms [W] Feb 18 00:47:26 https-dns-proxy: BC0A: curl request failed with 0: No error [W] Feb 18 00:47:26 https-dns-proxy: BC0A: curl error message: Failed to connect to cloudflare-dns.com port 443 after 906 ms: Operation timed out [W] Feb 18 00:47:26 https-dns-proxy: 4AC5: curl request failed with 0: No error [W] Feb 18 00:47:26 https-dns-proxy: 4AC5: curl error message: Failed to connect to cloudflare-dns.com port 443 after 1371 ms: Operation timed out ... [W] Feb 18 00:53:20 https-dns-proxy: E1E2: curl error message: Operation timed out after 3000 milliseconds with 0 bytes received [W] Feb 18 06:12:21 https-dns-proxy: 0963: curl request failed with 0: No error [W] Feb 18 06:12:21 https-dns-proxy: 0963: curl error message: Failed to connect to dns.google port 443 after 2252 ms: Operation timed out [W] Feb 18 06:12:21 https-dns-proxy: CB60: curl request failed with 0: No error [W] Feb 18 06:12:21 https-dns-proxy: CB60: curl error message: Operation timed out after 3002 milliseconds with 0 bytes received [W] Feb 18 06:12:31 https-dns-proxy: 4453: curl request failed with 0: No errorПО 38А5 на Viva

-

-

KN2710 - 37B1 syncthing все ОК

Скрытый текстMem: 348040K used, 153148K free, 456K shrd, 2568K buff, 63120K cached CPU: 0.9% usr 1.0% sys 0.1% nic 97.6% idle 0.0% io 0.1% irq 0.2% sirq Load average: 1.14 1.73 2.01 2/530 8776 PID PPID USER STAT VSZ %VSZ CPU %CPU COMMAND ... 1254 1245 root SN 842m171.8 0 0.1 syncthing 1108 1 root S 721m147.0 0 0.0 AdGuardHome -w /opt/home/AdGuardHome -l /opt/tmp/AdGuardHome.log --pidfile /opt/var/run/adguardhome.pid --no-ch 1245 1 root S 705m143.9 1 0.0 syncthing ... -

Сегодня 17.08.2021 года

Скрытый текст/opt/etc/init.d # ./K92syncthing start Starting syncthing... done. /opt/etc/init.d # ps PID USER VSZ STAT COMMAND 1 root 1100 S init 2 root 0 SW [kthreadd] 3 root 0 SW [kworker/0:0] ... 1767 root 0 SW [kworker/u8:0] 1781 root 666m S syncthing 1791 root 667m R syncthing 1807 root 3880 R ps /opt/etc/init.d # или /opt/etc/init.d # opkg remove syncthing /opt/etc/init.d # opkg install syncthing Installing syncthing (1.18.0-1) to root... Downloading http://bin.entware.net/mipselsf-k3.4/syncthing_1.18.0-1_mipsel-3.4.ipk Configuring syncthing. /opt/etc/init.d # ./K92syncthing start Starting syncthing... done. /opt/etc/init.d #v1.18.0, Linux (32-bit MIPS (LE)) все ОК запустилось без приколов, выход в WEB и настройки https://х.х.х.х.:ПОРТ (по умолчанию 8384)

-

В продолжение данной темы но спустя два года, тек. версия 37В4 роутер KN1010, клиент по свежей 2020года планшет Samsung T505.

Суть проверки как поведет себя данный клиент на Android 11 который может все 802.11/krv для WPA2 (с WPA3 нет поддержки 802.11r) на базе Qualcom 1х1, активные действия Samsung принимает при уровнях -75-85. Клиент находиться зоне RSSI равной -60 -80 посмотрим его переключения при использование Band Steering в данной зоне приема.

Скрытый текст[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::Wps: "WifiMaster0/AccessPoint0": WPS disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::Wps: "WifiMaster0/AccessPoint0": an auto self PIN mode disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Wifi: "WifiMaster0/AccessPoint0": WPA PSK set.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": wireless encryption enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": WPA enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": WPA2 enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": WPA3 disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": OWE disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Wireless: "WifiMaster0/AccessPoint0": SSID saved.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": SSID broadcasting enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": WMM extensions enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": RRM enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": BTM enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": fast transition MDID reset to default.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster0/AccessPoint0": fast transition disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Base: "WifiMaster0/AccessPoint0": interface is up.

[I] Aug 4 07:49:53 ndm: Network::Interface::Base: "WifiMaster0/AccessPoint0": schedule cleared.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::Wps: "WifiMaster1/AccessPoint0": WPS disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::Wps: "WifiMaster1/AccessPoint0": an auto self PIN mode disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Wifi: "WifiMaster1/AccessPoint0": WPA PSK set.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": wireless encryption enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": WPA enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": WPA2 enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": WPA3 disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": OWE disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Wireless: "WifiMaster1/AccessPoint0": SSID saved.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": SSID broadcasting enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": WMM extensions enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": RRM enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": BTM enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": fast transition MDID reset to default.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::AccessPoint: "WifiMaster1/AccessPoint0": fast transition disabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Base: "WifiMaster1/AccessPoint0": interface is up.

[I] Aug 4 07:49:53 ndm: Network::Interface::Base: "WifiMaster1/AccessPoint0": schedule cleared.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::WifiMaster: "WifiMaster1": band steering enabled.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::WifiMaster: "WifiMaster1": band steering preference is 5 GHz.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::Iapp: Bridge0 key unchanged.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::WpaEap: Bridge0 RADIUS server unchanged.

[I] Aug 4 07:49:53 ndm: Network::Interface::Rtx::WpaEap: Bridge0 RADIUS secret unchanged.

[I] Aug 4 07:49:53 ndm: Core::System::Configuration: saving (http/rci).

[I] Aug 4 07:49:56 kernel: br0: port 3(ra0) entered disabled state

[I] Aug 4 07:49:56 kernel: br0: port 2(ra5) entered disabled state

[I] Aug 4 07:49:56 kernel: 5GHz eLNA Gain: 11 -> 10

[I] Aug 4 07:49:56 kernel: 5GHz eLNA Bypass: 10 -> 9

[I] Aug 4 07:49:57 kernel: br0: port 2(ra5) entered blocking state

[I] Aug 4 07:49:57 kernel: br0: port 2(ra5) entered forwarding state

[I] Aug 4 07:49:57 kernel: IPv6: ADDRCONF(NETDEV_UP): ra0: link is not ready

[I] Aug 4 07:49:58 ndm: Core::System::Configuration: configuration saved.

[I] Aug 4 07:49:58 kernel: IPv6: ADDRCONF(NETDEV_CHANGE): ra0: link becomes ready

[I] Aug 4 07:49:58 kernel: br0: port 3(ra0) entered blocking state

[I] Aug 4 07:49:58 kernel: br0: port 3(ra0) entered forwarding state

[I] Aug 4 07:50:00 bndstrg: band steering control daemon v1.0-28 started

[I] Aug 4 07:50:02 coalagent: updating configuration...

[I] Aug 4 07:50:02 bndstrg: band steering: enabled

[I] Aug 4 07:50:15 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had associated successfully.

[I] Aug 4 07:50:15 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:50:15 ndhcps: DHCPDISCOVER received from 14:........:14.

[I] Aug 4 07:50:15 ndhcps: making OFFER of 192.168.1.8 to 14:........:14.

[I] Aug 4 07:50:16 ndhcps: DHCPREQUEST received (STATE_SELECTING) for 192.168.1.8 from 14:........:14.

[I] Aug 4 07:50:16 ndhcps: sending ACK of 192.168.1.8 to 14:........:14.[I] Aug 4 07:52:15 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -89)

[I] Aug 4 07:52:15 bndstrg: band steering: WNM client 14:........:14 accepted 2.4GHz band

[I] Aug 4 07:52:15 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:52:15 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:52:27 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:52:27 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:52:33 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -89)

[I] Aug 4 07:52:33 bndstrg: band steering: WNM client 14:........:14 accepted 2.4GHz band

[I] Aug 4 07:52:33 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:52:33 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:52:57 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:52:57 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:53:02 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -89)

[W] Aug 4 07:53:02 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:53:12 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -89)

[I] Aug 4 07:53:12 bndstrg: band steering: WNM client 14:........:14 accepted 2.4GHz band

[I] Aug 4 07:53:12 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:53:12 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:54:21 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:54:21 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:54:27 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -86)

[W] Aug 4 07:54:27 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:54:37 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -86)

[W] Aug 4 07:54:38 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:54:57 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -84)

[W] Aug 4 07:54:57 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:55:42 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:55:42 wmond: WifiMaster0/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:55:57 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had re-associated successfully.

[I] Aug 4 07:55:57 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) set key done in WPA2/WPA2PSK.

[I] Aug 4 07:56:02 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -87)

[W] Aug 4 07:56:02 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:56:12 bndstrg: band steering: send BTM request to 14:........:14 for roam to 2.4GHz band (Low RSSI: -89)

[W] Aug 4 07:56:12 bndstrg: band steering: WNM client 14:........:14 rejected 2.4GHz band (code: 7)

[I] Aug 4 07:56:16 wmond: WifiMaster1/AccessPoint0: (MT7615) STA(14:........:14) had deauthenticated by STA (reason: STA is leaving or has left BSS).Вопрос по 5 переключениям в период ~1минуты T1-T5

Маленькая t. это rescan клиента.

Syncthing

in Opkg Cookbook

Posted

На mipsle

#!/bin/sh if [ ! -d "/opt/etc/syncthing" ]; then syncthing -generate="/opt/etc/syncthing" sed -i 's|127\.0\.0\.1|0.0.0.0|' /opt/etc/syncthing/config.xml elif [ -n "$(grep '127\.0\.0\.1' /opt/etc/syncthing/config.xml)" ]; then sed -i 's|127\.0\.0\.1|0.0.0.0|' /opt/etc/syncthing/config.xml fi ENABLED=yes PROCS=syncthing #ARGS="-gui-address=0.0.0.0:8384 --logfile=/opt/var/syncthing_log" ARGS="--logfile=/opt/var/syncthing_log" PREARGS="" DESC=$PROCS PATH=/opt/sbin:/opt/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin . /opt/etc/init.d/rc.funcи в итоге

/opt/etc/init.d # ./K92syncthing start Starting syncthing... done. /opt/etc/init.d # ps ... 10529 root 544m S syncthing --logfile=/opt/var/syncthing_log 10542 root 544m S /opt/bin/syncthing --logfile=/opt/var/syncthing_log 10554 root 3676 R ps /opt/etc/init.d # netstat -ntulp | grep sync tcp 0 0 192.168.1.8:8384 0.0.0.0:* LISTEN 10542/syncthing tcp 0 0 :::22000 :::* LISTEN 10542/syncthing udp 0 0 0.0.0.0:21027 0.0.0.0:* 10542/syncthing udp 0 0 0.0.0.0:58515 0.0.0.0:* 10542/syncthing udp 0 0 :::21027 :::* 10542/syncthing udp 0 0 :::58707 :::* 10542/syncthing udp 0 0 :::22000 :::* 10542/syncthing /opt/etc/init.d #Доступ к WЕB - 192.168.1.8:8384. Создвнный конф файл будет в /opt/etc/syncthing и там же *.pem

В WEB роутера на странице OPKG в поле сценария должно быть прописано - /opt/etc/init.d/rc.unslung